|

|

联邦学习中的隐私问题研究进展 | jos佳文

软件学报 2023-02-10 17:40 发表于北京

原文链接:联邦学习中的隐私问题研究进展 | jos佳文

文章题目: 联邦学习中的隐私问题研究进展

全部作者: 汤凌韬, 陈左宁, 张鲁飞, 吴东

第一单位: 数学工程与先进计算国家重点实验室

出版时间: 2023,34(1):197-229

摘

/

要

ABSTRACT

ABSTRACT

随着大数据、云计算等领域的蓬勃发展, 重视数据安全与隐私已经成为世界性的趋势, 不同团体为保护自身利益和隐私不愿贡献数据, 形成了数据孤岛. 联邦学习使数据不出本地就可被多方利用, 为解决数据碎片化和数据隔离等问题提供了解决思路. 然而越来越多研究表明, 由谷歌首先提出的联邦学习算法不足以抵抗精心设计的隐私攻击, 因此如何进一步加强隐私防护, 保护联邦学习场景下的用户数据隐私成为一个重要问题. 对近些年来联邦学习隐私攻击与防护领域取得的成果进行了系统总结. 首先介绍了联邦学习的定义、特点和分类; 然后分析了联邦学习场景下隐私威胁的敌手模型, 并根据敌手攻击目标对隐私攻击方法进行了分类和梳理; 介绍了联邦学习中的主流隐私防护技术, 并比较了各技术在实际应用中的优缺点; 分析并总结了6类目前联邦学习的隐私保护方案; 最后指出目前联邦学习隐私保护面临的挑战, 展望了未来可能的研究方向.

编辑 编辑

编辑 编辑

扫码阅读全文

内

/

容

/

精

/

选

CONTENT

CONTENT

联邦学习中的隐私保护是一个交叉性极强的研究方向, 要系统地厘清隐私威胁并提出防护方法需要跨学科的努力. 为达到理论安全性, 目前有大量工作引入密码学技术保护模型的训练和推理过程, 如安全多方计算(secure multi-party computation, MPC)、同态加密(homomorphic encryption, HE)、函数加密(functional encryption, FE)和差分隐私(differential privacy, DP)等. 以SGX为代表的可信执行环境(trusted execution environment, TEE)同样为联邦学习中的隐私保护提供了解决思路. 本文主要研究联邦学习中隐私问题, 总结相关研究进展.

(1) 联邦学习

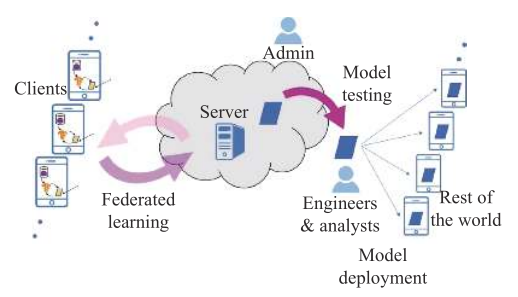

联邦学习是一种机器学习场景, 多个客户端在一个或多个中央服务器的帮助下合作解决一个机器学习问题. 每个客户端的原数据存储在本地且不对外传输. 中央服务器通过对客户端上传的参数更新进行聚合以达到学习目标. 实际应用场景中联邦学习是由任务驱动的, 图1展示了FLS中学习模型的生命周期以及各类参与角色, 当特定问题被识别和建模后, 由模型工程师发布任务并开始完整的学习流程, 最后对生成的模型进行测试分析和实际部署.

编辑 编辑

图1 联邦学习系统中的模型生命周期及各类角色

(2) 联邦学习中的隐私威胁

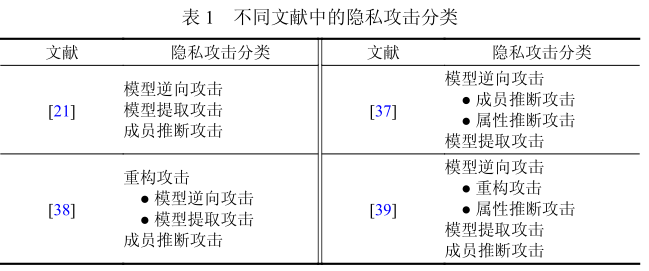

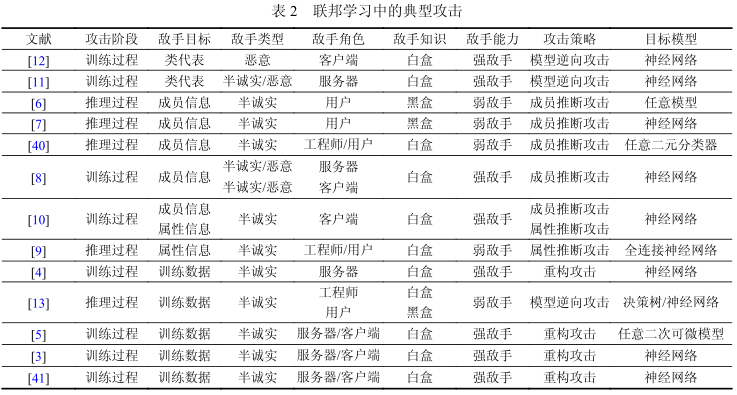

隐私问题是联邦学习的核心问题. 提及机器学习系统面临的威胁时, 安全与隐私往往被混为一谈. 隐私攻击是系统面临的威胁的一部分, 敌手为了窃取用户原数据或训练好的模型参数等隐私信息, 发起隐私攻击. 而安全攻击则是通过妨碍模型正常训练或诱导模型错误预测等手段, 危害系统的准确性和鲁棒性, 目前已有相关研究验证了投毒攻击(poisoning attack)和对抗攻击(adversarial attack)在联邦学习场景中的可行性. 本文主要关注联邦学习中用户数据的隐私保护问题, 分析了不同敌手角色存在时的隐私威胁模型, 如表1所示; 总结了联邦学习系统中常见的隐私攻击, 如表2所示.

编辑 编辑

编辑 编辑

(3) 联邦学习中的隐私保护技术

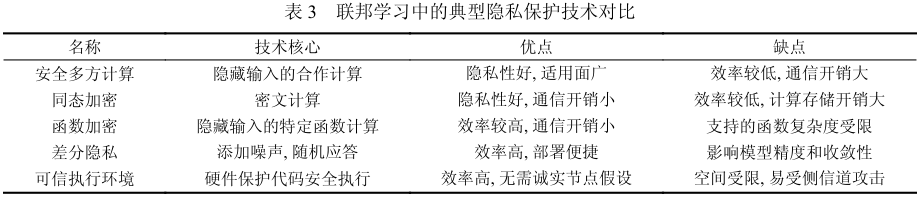

机器学习领域内部的技术不能很好地抵抗上述各类隐私攻击, 对此研究人员将密码学和可信硬件等技术引入联邦学习, 通过密码技术的理论安全性以及可信硬件的物理层面安全来保障用户隐私. 目前面向联邦学习的隐私保护涉及的技术主要分为3类.

① 加密方法: 参与方在不交换明文的情况下, 进行安全的分布式计算. 相关技术包括安全多方计算、同态加密、函数加密等. 此类方法有效隐藏了计算输入和一些中间变量, 限制了敌手获取额外知识的能力, 从而影响敌手攻击成功率甚至直接使其攻击策略失效.

② 扰动方法: 参与方通过对数据添加噪声等方法获取可量化的隐私保证. 典型技术为差分隐私, 保证不同训练样本对最终模型的影响一定程度上不可区分, 从而抵抗敌手获取特定数据的隐私信息.

③ 可信硬件: 参与方将数据加密, 在可信执行环境下执行数据解密及指定计算, 通过物理层面的安全性保证敌手无法接触原数据或推理相关信息. 典型架构有intel SGX、Sanctum等.

下表对这些技术的特点进行了对比总结.

编辑 编辑

(4) 联邦学习中的隐私保护方案

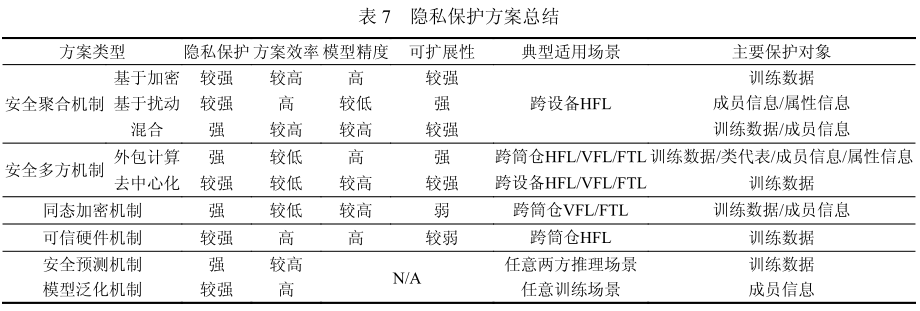

本文依据作用阶段、防护策略及所用技术, 将这些隐私保护方案分为6大类: 安全聚合机制、安全多方机制、同态加密机制、可信硬件机制、安全预测机制、模型泛化机制. 首先, 前4种机制作用于训练过程, 安全预测机制作用于推理过程, 模型泛化机制可令两个阶段同时受益. 其次, 训练过程的4种机制主要区别在于对数据的保护策略, 安全聚合机制遵循用户数据不出本地的核心思想, 通过交换中间参数进行训练. 其余3种机制则允许数据加密后传出本地, 而其特点和应用场景又因采用的技术产生区分: 安全多方机制允许数据通过安全的方式共享以进行模型训练, 同时保证其在计算过程中的隐私性, 直至计算结果公布; 同态加密机制利用密文计算技术, 保证数据加密后的隐私性和计算正确性; 可信硬件机制则通过硬件层面的安全保证计算时数据不被破解. 根据隐私性、高效性、可扩展性、适用场景等方面, 对本节隐私方案的横向对比总结如下表所示.

编辑 编辑

(5) 总结与展望

目前联邦学习尚处于研究起步阶段, 不同于传统机器学习中的隐私问题, 新的攻击形式和场景需求对隐私保护提出了更严苛的挑战. 本文结合现有工作中的问题, 指出联邦学习中隐私保护面临的挑战, 并提出未来值得研究的方向.

● 平衡隐私保护、模型精度、算法效率的矛盾

● 建立隐私泄露和隐私保护程度的度量标准

● 研究去中心化架构的联邦学习隐私保护方案

● 研究面向移动边缘设备的联邦学习隐私保护方案

● 加强纵向联邦学习和迁移学习的隐私问题研究

● 加强图像数据的隐私保护

● 解决参与方的激励问题和建立公平性准则

联邦学习的出现有效解决了数据孤岛的问题, 充分挖掘了边缘设备、移动设备中存储数据的价值, 然而敌手可通过隐私攻击获取训练数据的相关信息, 严重威胁了正常的训练和推理过程, 危害参与方的隐私权益, 为联邦学习的系统设计及相关标准的制定带来了巨大挑战.

本文深入分析了联邦学习的定义、特点和分类, 描述了联邦学习系统可能面临隐私攻击的敌手模型和攻击类型, 总结并分析了隐私攻击和隐私保护的最新研究, 对联邦学习中的隐私保护方法进行归纳和抽象, 并指出了现有方案中存在的问题, 探讨了未来的挑战和值得研究的方向. 总之, 在平衡好隐私保护、模型精度和算法效率的前提下, 如何根据特定应用场景设计有针对性的隐私保护方案, 最小化用户隐私泄露风险, 是一个长期的挑战, 需要持续跟进与研究.

作

/

者

/

简

/

介

AUTHOR

AUTHOR

编辑 编辑

汤凌韬, 博士生, CCF学生会员, 主要研究领域为信息安全, 机器学习隐私保护.

编辑 编辑

陈左宁, 博士, 博士生导师, 中国工程院院士, CCF会士, 主要研究领域为软件理论, 操作系统, 信息安全.

编辑 编辑

张鲁飞, 博士, 工程师, 主要研究领域为高性能计算, 操作系统, 机器学习.

编辑 编辑

吴东, 博士, 研究员, 主要研究领域为人工智能, 密码学.

[url=]阅读原文[/url]

|

|